През 2024 г. светът става свидетел на рекорден брой избори, с участието на народи от над 90 държави и население, надхвърлящо 4 милиарда души – повече от половината от населението на света. Въпреки това, всички тези избори се провеждат в среда, в която дълбоките фалшификати (deepfakes) са все по-реалистични и широко разпространени.

Фразата „дълбоки фалшификати“ може да се дефинира като „неподходящи или грубо подвеждащи гласове, изображения или видеоклипове, генерирани от изкуствен интелект, които разумен човек би приел за истински“.

Според скорошно проучване на DeepMind, подразделението за изкуствен интелект на Google, дълбоките фалшификати, имитиращи политици и известни личности, са много по-разпространени, отколкото се предполагаше досега. По-конкретно, изследователите стигат до заключението, че създаването на фалшиви изображения, видеоклипове и аудиозаписи на публични фигури е почти два пъти по-често срещано в сравнение с други видове злоупотреби. Например, през последните месеци в социалните мрежи TikTok, X и Instagram се появиха дълбоки фалшификати на Доналд Тръмп, Джо Байдън, Риши Сунак и дори на Папа Франциск.

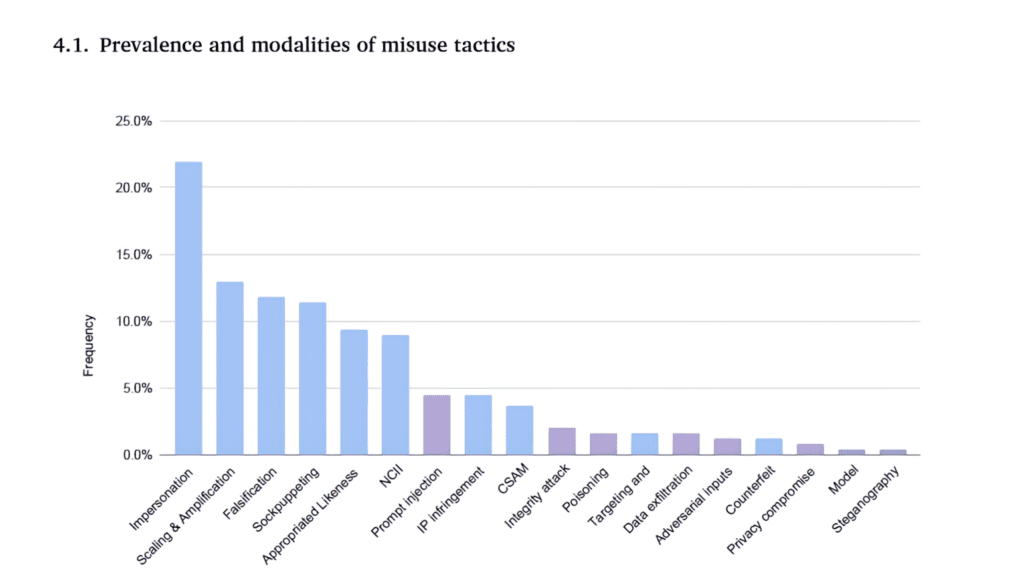

Учените от Google DeepMind са анализирали над 200 случая на злоупотреба, регистрирани между януари 2023 г. и март 2024 г. Резултатите показват, че дълбоките фалшификати най-често се използват за имитация на личности (22%). Това включва използването на AI за имитиране на гласове или образи на реални хора, често обществени фигури, с цел измама. На второ място е манипулацията на общественото мнение, която съставлява 13% от случаите и включва генериране на големи обеми от текстове, изображения или видеа за разпространение на дезинформация или спам. Фалшификацията, която включва създаване на фалшиви документи, изображения или видеа, представлява 12% от случаите. Използването на синтетични личности, или така нареченото „sockpuppeting“, е отчетено в 9% от случаите, докато неконсенсуалното интимно съдържание (NCII) съставлява 8% от случаите. Материалите за сексуална злоупотреба с деца (CSAM) представляват 4% от случаите.

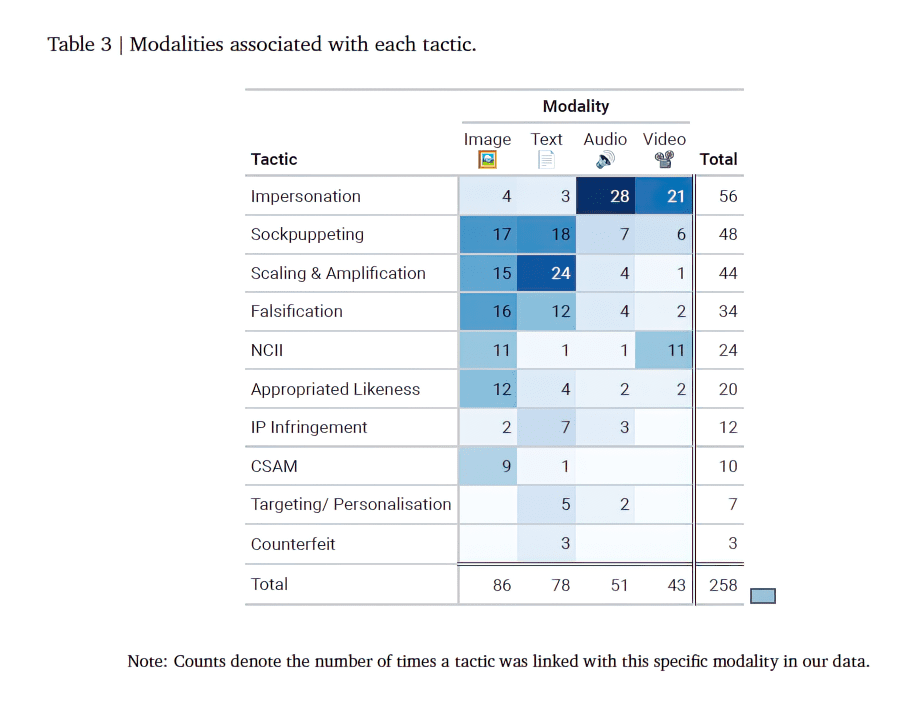

Анализът на DeepMind също така разкрива утвърдените и нови начини на злоупотреба, включително потенциални мотиви, стратегии и методи, по които нападателите използват и злоупотребяват с възможностите на системите в различни модалности (напр. изображение, текст, аудио и видео).

Учените подчертават, че преодоляването на предизвикателствата, свързани със злоупотребите с изкуствен интелект, изисква многостранен подход, включващ сътрудничество между законодатели, изследователи, индустриални лидери и гражданското общество. Организацията акцентира и върху необходимостта от по-задълбочено разбиране на социалните и психологическите фактори, допринасящи за злоупотребите с изкуствен интелект.

DeepMind не са единствените притеснени от дълбоките фалшификати. През февруари над 800 видни учени и специалисти по изкуствен интелект, като Йошуа Бенгио, Стюарт Ръсел, Дан Хендрикс, както и изследователи от OpenAI, подписаха отворено писмо, в което призовават за “по-строго регулиране на дълбоките фалшификати“.

В връзка с това, ControlAI, една от организациите, които обръщат сериозно внимание на опасностите, свързани с този тип измами, наскоро публикува доста интересен и информативен видеоклип, в който демонстрира колко лесно всеки от нас може да бъде заблуден от технологиите за създаване на синтетични гласове.

“Hi Dad, you alright? Just a quick one, are you in later? I’ve been an idiot and left my keys, would you be able to leave the upstairs kitchen door on the latch?”

— ControlAI (@ai_ctrl) February 12, 2024

“Dad, that wasn’t me, I’m doing this thing in the studio, an AI thing, that was a deepfake of my voice…isn’t that… pic.twitter.com/o0lC8pOjOZ

В България също наскоро бе създадена организаци, наречена AI Safety Bulgaria, която има за цел „да повиши осведомеността на българските граждани относно рисковете, свързани с изкуствения интелект“.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!