През последните месеци нарастващата тревожност относно бързото развитие и потенциалните опасности от изкуствения интелект е изключително силно изразена както сред обществото, така и сред експертите и изследователите в областта на AI.

През март, Институтът за Бъдещето на Живота инициира отворено писмо, призоваващо за временно прекъсване на обучението на AI системи, по-мощни от GPT-4, което събра подписите на множество експерти, видни изследователи и предприемачи, сред които и Илон Мъск.

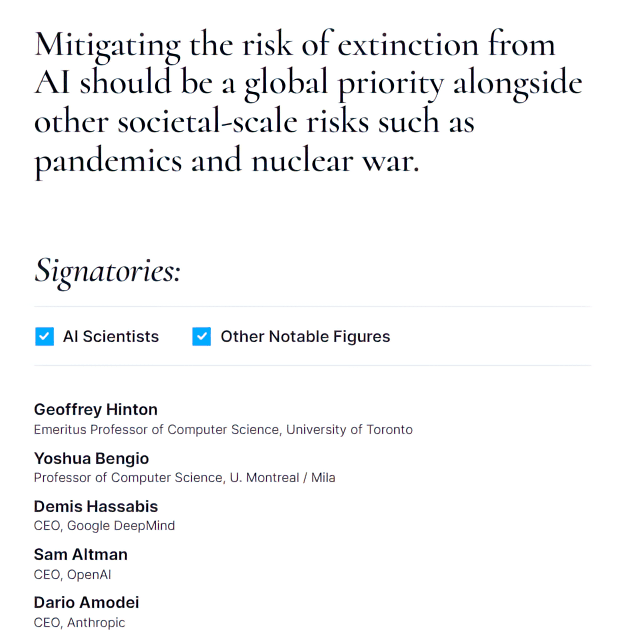

През май в изявление, организирано от Центъра за безопасност на изкуствения интелект, беше заявено, че:

Намаляването на риска от изчезване, причинено от изкуствения интелект, трябва да бъде глобален приоритет наред с други рискове от обществен мащаб като пандемии и ядрена война.

Вчера, 24 октомври, група експерти, сред които носителите на наградата „Тюринг“ Джефри Хинтън и Йошуа Бенгио, публикуваха статия, в който призовават правителствата да предприемат действия за управление на рисковете, свързани с изкуствения интелект.

Авторите, които са представители на престижни институции от цял свят, изразяват своята загриженост относно потенциалните широкомащабни рискове, свързани с мощните системи за изкуствен интелект, които биха могли да надминат човешките способности в множество когнитивни задачи. В статията се посочва:

През последните години, развитието на изкуствения интелект е бързо и непредвидимо, като системите стават все по-автономни и способни. От неспособността на GPT-2 да брои до десет през 2019 г., сега виждаме системи, които могат да пишат софтуер, да генерират реалистични изображения и да дават съвети по сложни теми. С увеличаването на мащаба системите проявяват нови възможности и поведение, които дори не са били предварително програмирани.

Тези постижения и наличието на значителни финансови ресурси от технологичните компании подчертават спешната необходимост от предприемане на действия за управление и гарантиране на безопасността на AI технологиите.

Особено внимание се обръща на екстремните рискове, които могат да бъдат породени от най-съвременните системи с изкуствен интелект, включително възможността те да бъдат използвани за мащабни престъпни или терористични дейности.

В статията експертите, предлагат редица конкретни политически препоръки. Сред тях е идеята големите технологични компании да отделят поне една трета от бюджетите си за научни изследвания и разработки в областта на изкуствения интелект за проекти, които насърчават безопасното и етично използване на технологиите.

Друга препоръчанa политика е да се изисква от компаниите да поискат лиценз, преди да разработят „изключително способни бъдещи модели„.

Авторите също така призовават за създаване на национални и международни стандарти. Те настояват за създаването на институции и управленски органи, които да имат техническата експертиза и правомощията да наблюдават и контролират разработването и прилагането на изкуствения интелект.

Бенгио, научен директор в Института за изучаване на алгоритми в Монреал, казва, че статията има за цел да помогне на политиците, медиите и широката общественост „да разберат рисковете и някои от нещата, които трябва да направим, за да накараме AI системите да правят това, което искаме„.

Искахме да представим това, което (според нас) е ясна позиция по отношение на безопасността на изкуствения интелект, достатъчно освободена от влиянието на лични интереси

– заяви Стюарт Ръсел, професор по компютърни науки в Калифорнийския университет в Бъркли и съавтор на статията, за TIME.

Ако правителствата действат решително сега, има шанс да се научим как да направим AI системите безопастни, преди да се научим как да ги направим толкова мощни, че да станат неконтролируеми

– категоричен е той.