NVIDIA обяви ново тестово приложение, наречено „Chat with RTX“. То позволява създаването на персонализирани чатботове с помощта на големи езикови модели (LLM), подобно на персонализираните GPT-та на OpenAI. Разликата е, че те работят локално на компютри или работни станции, които разполагат с видеокарти NVIDIA RTX.

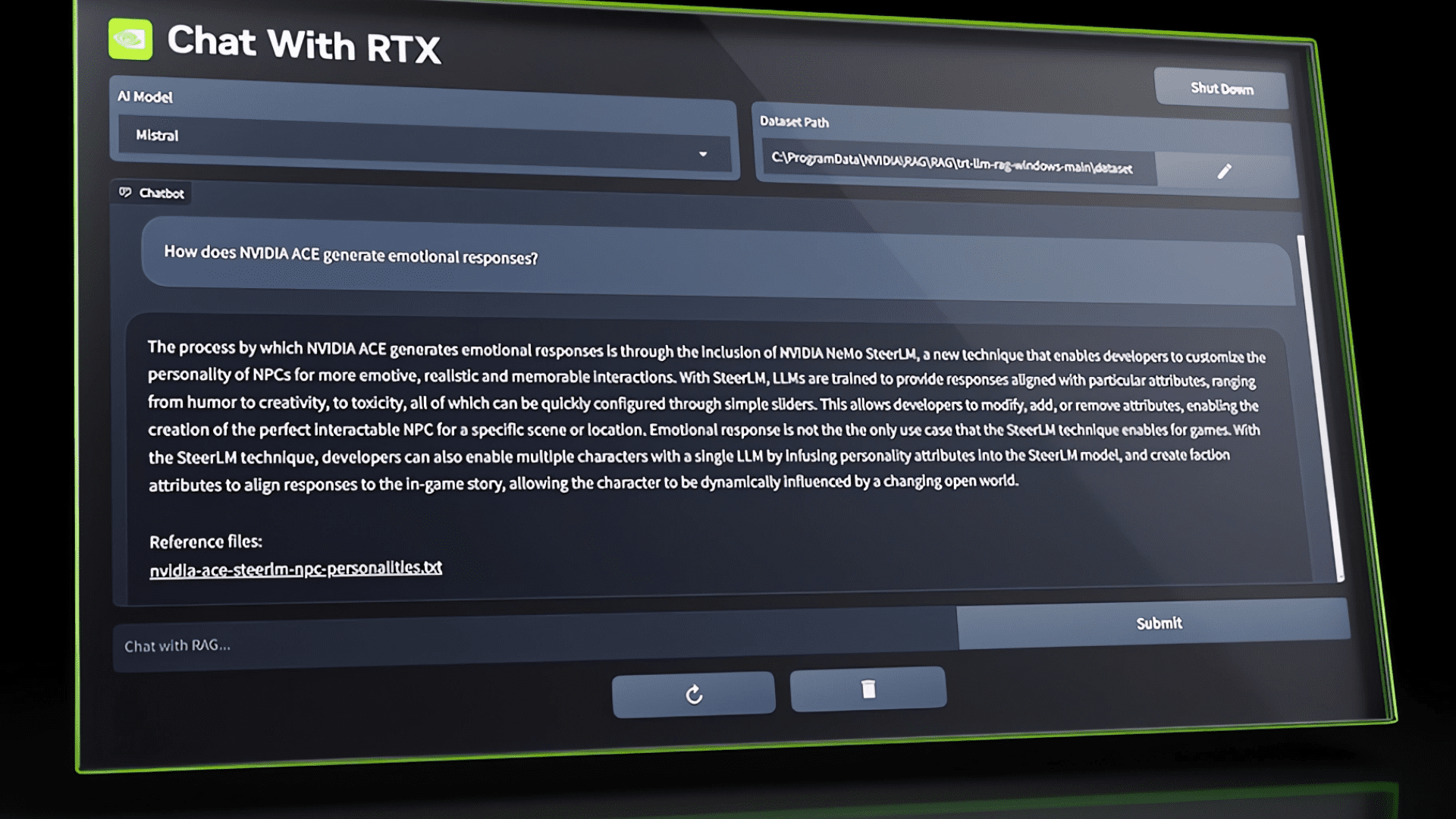

Въпросните чатботове могат да използват информация, предоставена от потребителя, като например документи, бележки, видеоклипове или други данни, за да предоставят контекстуално подходящи отговори.

Chat with RTX поддържа различни файлови формати, включително текст, PDF, doc/docx и XML. Потребителите просто трябва да насочат приложението към папките, съдържащи необходимите файлове, и то ще ги зареди в базата данни. Освен това могат да посочат URL адрес на плейлист в YouTube и приложението ще зареди транскрипциите на видеоклиповете в плейлиста и ще ги направи достъпни за четене.

NVIDIA обяви, че приложението ще бъде налично в края на този месец. Можете да се регистрирате тук, за да получите известие, когато то стане достъпно.

Chat with RTX е базиран на проекта TensorRT-LLM RAG, наличен в GitHub. Според Nvidia разработчиците могат да го използват, за да създават и внедряват своите RAG-базирани RTX приложения, работещи с TensorRT-LLM.

Стартирането на Chat with RTX от NVIDIA е част от по-широките усилия на компанията да популяризира генеративния изкуствен интелект сред потребителите, използващи графични процесори RTX. Новото поколение видеокарти, от серията RTX 40 SUPER, които Nvidia обяви на CES 2024, са способни да изпълняват широк набор от AI модели локално на компютър или работна станция.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!